در اقدامی که توجه بسیاری را به خود جلب کرده است، هوش مصنوعی Perplexity نسخه جدیدی از یک مدل زبانی متنباز محبوب را منتشر کرده است که سانسور داخلی چینی را حذف میکند. این مدل اصلاحشده، R1 1776 نام دارد (نامی که یادآور روحیه استقلال است)، بر اساس DeepSeek R1 توسعهیافته در چین است. DeepSeek R1 اصلی به دلیل قابلیتهای استدلال قوی خود مشهور شد - که گفته میشود با مدلهای برتر با کسری از هزینه رقابت میکند - اما با یک محدودیت قابل توجه همراه بود: از پرداختن به موضوعات حساس خاص خودداری میکرد.

چرا این موضوع مهم است؟

این موضوع سؤالات مهمی را در مورد نظارت هوش مصنوعی، تعصب، باز بودن و نقش ژئوپلیتیک در سیستمهای هوش مصنوعی مطرح میکند. این مقاله به بررسی این موضوع میپردازد که Perplexity دقیقاً چه کاری انجام داد، پیامدهای غیرسانسوری کردن مدل چیست و چگونه در گفتگوی بزرگتر در مورد شفافیت و سانسور هوش مصنوعی جای میگیرد.

چه اتفاقی افتاد: DeepSeek R1 غیرسانسوری میشود

DeepSeek R1 یک مدل زبانی بزرگ با وزن باز است که در چین نشأت گرفته و به دلیل تواناییهای استدلال عالی خود مشهور شده است - حتی به عملکرد مدلهای پیشرو نزدیک میشود - در حالی که از نظر محاسباتی کارآمدتر است. با این حال، کاربران به سرعت متوجه یک نکته عجیب شدند: هر زمان که پرسشها به موضوعاتی حساس در چین مربوط میشد (به عنوان مثال، جنجالهای سیاسی یا رویدادهای تاریخی که توسط مقامات تابو تلقی میشوند)، DeepSeek R1 مستقیماً پاسخ نمیداد. در عوض، با اظهارات از پیش تعیینشده و مورد تأیید دولت یا امتناع صریح پاسخ میداد که نشاندهنده قوانین سانسور دولت چین است. این تعصب داخلی، سودمندی مدل را برای کسانی که به دنبال بحثهای صریح یا ظریف در مورد این موضوعات هستند، محدود میکرد.

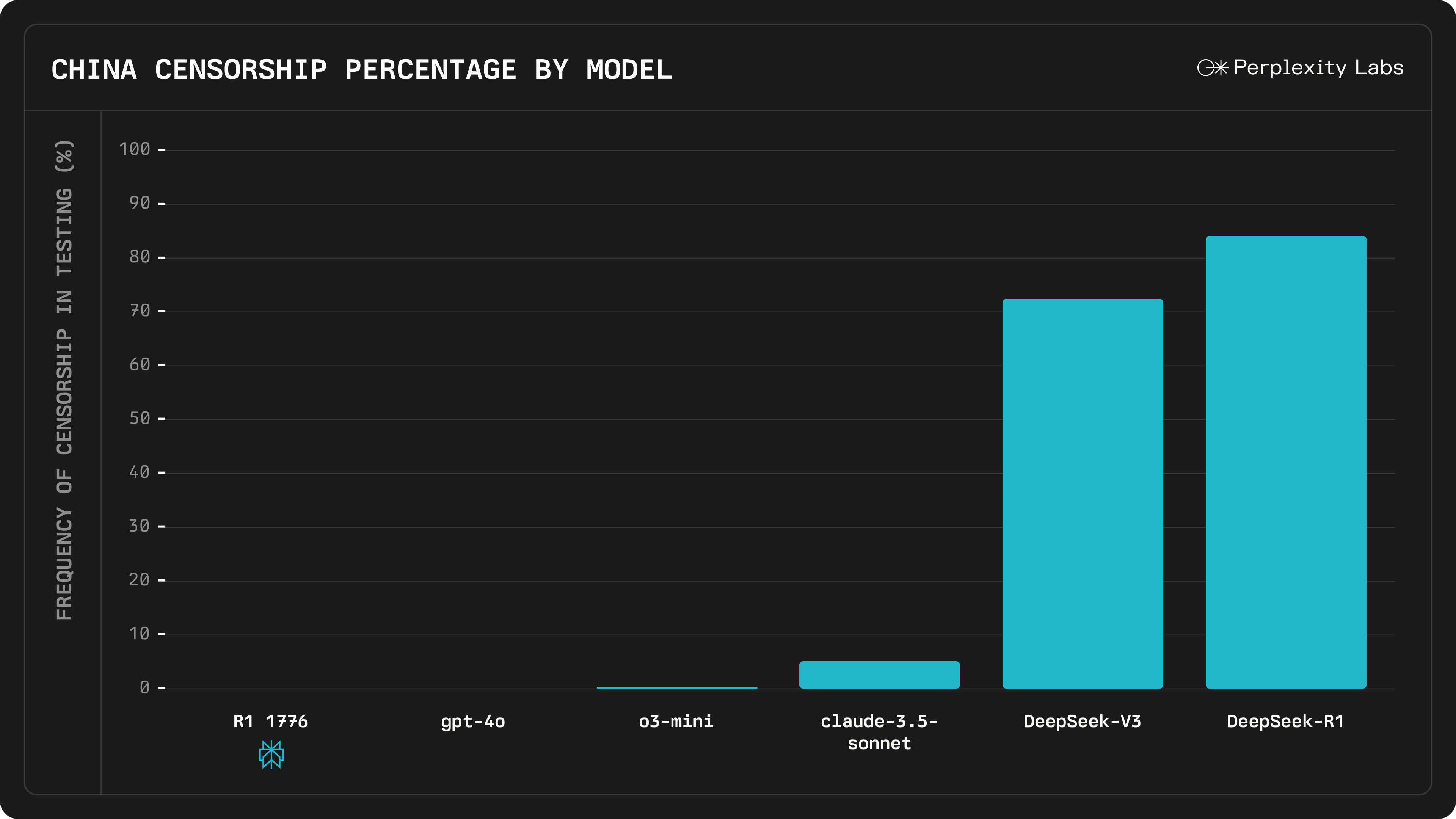

راهحل هوش مصنوعی Perplexity این بود که از طریق یک فرآیند گسترده پس از آموزش، مدل را "غیرسانسوری" کند. این شرکت مجموعه داده بزرگی از 40000 اعلان چند زبانه را جمعآوری کرد که سؤالاتی را پوشش میداد که DeepSeek R1 قبلاً سانسور کرده بود یا به طور مبهم به آنها پاسخ داده بود. با کمک کارشناسان انسانی، آنها تقریباً 300 موضوع حساس را شناسایی کردند که در آن مدل اصلی تمایل داشت از خط حزب پیروی کند. برای هر یک از این اعلانها، این تیم پاسخهای واقعی و منطقی را به چندین زبان تنظیم کرد. این تلاشها به یک سیستم تشخیص و اصلاح سانسور چند زبانه وارد شد، که اساساً به مدل آموزش میداد که چگونه تشخیص دهد چه زمانی سانسور سیاسی را اعمال میکند و به جای آن با یک پاسخ آموزنده پاسخ دهد. پس از این تنظیم دقیق ویژه (که Perplexity برای برجسته کردن موضوع آزادی، آن را "R1 1776" نامید)، مدل به طور آزادانه در دسترس قرار گرفت. Perplexity ادعا میکند که فیلترها و تعصبات سانسور چینی را از پاسخهای DeepSeek R1 حذف کرده است، بدون اینکه قابلیتهای اصلی آن را تغییر دهد.

نکته مهم این است که R1 1776 در مورد سؤالاتی که قبلاً تابو بودند، بسیار متفاوت عمل میکند. Perplexity مثالی ارائه داد که شامل پرسشی در مورد استقلال تایوان و تأثیر بالقوه آن بر قیمت سهام NVIDIA بود - یک موضوع از نظر سیاسی حساس که به روابط چین و تایوان مربوط میشود. DeepSeek R1 اصلی از این سؤال اجتناب کرد و با کلیشههای همسو با حکچ پاسخ داد. در مقابل، R1 1776 یک ارزیابی دقیق و صریح ارائه میدهد: در مورد خطرات ملموس ژئوپلیتیکی و اقتصادی (اختلالات زنجیره تأمین، نوسانات بازار، درگیری احتمالی و غیره) که میتواند بر سهام NVIDIA تأثیر بگذارد، بحث میکند.

Perplexity با متنباز کردن R1 1776، وزنها و تغییرات مدل را برای جامعه شفاف کرده است. توسعهدهندگان و محققان میتوانند آن را از Hugging Face دانلود کنند و حتی از طریق API آن را ادغام کنند، و اطمینان حاصل کنند که حذف سانسور میتواند مورد بررسی دقیق قرار گیرد و توسط دیگران توسعه یابد.

پیامدهای حذف سانسور

تصمیم هوش مصنوعی Perplexity برای حذف سانسور چینی از DeepSeek R1 پیامدهای مهمی برای جامعه هوش مصنوعی دارد:

- افزایش باز بودن و صداقت: کاربران R1 1776 اکنون میتوانند پاسخهای مستقیم و غیرسانسوری را در مورد موضوعاتی که قبلاً ممنوع بودند، دریافت کنند، که یک پیروزی برای پرسشگری باز است. این میتواند آن را به یک دستیار قابل اعتمادتر برای محققان، دانشجویان یا هر کسی که در مورد سؤالات حساس ژئوپلیتیکی کنجکاو است تبدیل کند. این یک نمونه عینی از استفاده از هوش مصنوعی متنباز برای مقابله با سرکوب اطلاعات است.

- حفظ عملکرد: نگرانیهایی وجود داشت مبنی بر اینکه تغییر مدل برای حذف سانسور ممکن است عملکرد آن را در زمینههای دیگر کاهش دهد. با این حال، Perplexity گزارش میدهد که مهارتهای اصلی R1 1776 - مانند ریاضیات و استدلال منطقی - با مدل اصلی برابری میکند. در آزمایشها بر روی بیش از 1000 مثال که طیف گستردهای از پرسشهای حساس را پوشش میدهد، مشخص شد که این مدل "به طور کامل غیرسانسوری" است و در عین حال همان سطح دقت استدلال را به عنوان DeepSeek R1 حفظ میکند. این نشان میدهد که حذف تعصب (حداقل در این مورد) به قیمت هوش یا توانایی کلی تمام نشده است، که نشانه دلگرمکنندهای برای تلاشهای مشابه در آینده است.

- دریافت مثبت جامعه و همکاری: Perplexity با متنباز کردن مدل غیرسانسوری، از جامعه هوش مصنوعی دعوت میکند تا کار آنها را بررسی و بهبود بخشد. این نشاندهنده تعهد به شفافیت است - معادل هوش مصنوعی نشان دادن کار خود. علاقهمندان و توسعهدهندگان میتوانند تأیید کنند که محدودیتهای سانسور واقعاً از بین رفتهاند و به طور بالقوه به اصلاحات بیشتر کمک کنند. این امر اعتماد و نوآوری مشارکتی را در صنعتی تقویت میکند که در آن مدلهای بسته و قوانین تعدیل پنهان رایج است.

- ملاحظات اخلاقی و ژئوپلیتیکی: از طرف دیگر، حذف کامل سانسور سؤالات اخلاقی پیچیدهای را مطرح میکند. یکی از نگرانیهای فوری این است که چگونه از این مدل غیرسانسوری ممکن است در زمینههایی که موضوعات سانسور شده غیرقانونی یا خطرناک هستند استفاده شود. به عنوان مثال، اگر کسی در سرزمین اصلی چین از R1 1776 استفاده کند، پاسخهای غیرسانسوری مدل در مورد میدان تیانآنمن یا تایوان میتواند کاربر را در معرض خطر قرار دهد. همچنین سیگنال ژئوپلیتیکی گستردهتری وجود دارد: تغییر یک مدل چینیالاصل توسط یک شرکت آمریکایی برای به چالش کشیدن سانسور چینی را میتوان به عنوان یک موضع ایدئولوژیک جسورانه تلقی کرد. خود نام "1776" بر موضوع آزادی تأکید دارد که مورد توجه قرار نگرفته است. برخی از منتقدان استدلال میکنند که جایگزینی یک مجموعه تعصب با مجموعه دیگر امکانپذیر است - اساساً این سؤال را مطرح میکنند که آیا این مدل اکنون ممکن است دیدگاه غربی را در زمینههای حساس منعکس کند یا خیر. این بحث نشان میدهد که سانسور در مقابل باز بودن در هوش مصنوعی فقط یک مسئله فنی نیست، بلکه یک مسئله سیاسی و اخلاقی است. جایی که یک شخص تعدیل ضروری را میبیند، دیگری سانسور را میبیند، و یافتن تعادل مناسب دشوار است.

حذف سانسور تا حد زیادی به عنوان گامی به سوی مدلهای هوش مصنوعی شفافتر و مفیدتر در سطح جهانی جشن گرفته میشود، اما همچنین به عنوان یادآوری عمل میکند که آنچه هوش مصنوعی باید بگوید یک سؤال حساس و بدون توافق جهانی است.

تصویر بزرگتر: سانسور هوش مصنوعی و شفافیت متنباز

راهاندازی R1 1776 توسط Perplexity در زمانی انجام میشود که جامعه هوش مصنوعی با سؤالاتی در مورد چگونگی برخورد مدلها با محتوای بحثبرانگیز دست و پنجه نرم میکند. سانسور در مدلهای هوش مصنوعی میتواند از بسیاری از جاها ناشی شود. در چین، شرکتهای فناوری ملزم به ایجاد فیلترهای سختگیرانه و حتی پاسخهای کدگذاریشده برای موضوعات حساس سیاسی هستند. DeepSeek R1 نمونه بارز این موضوع است - این یک مدل متنباز بود، اما به وضوح اثر انگشت هنجارهای سانسور چین را در آموزش و تنظیم دقیق خود داشت. در مقابل، بسیاری از مدلهای توسعهیافته غربی، مانند GPT-4 OpenAI یا LLaMA متا، ملزم به رعایت دستورالعملهای حکچ نیستند، اما هنوز لایههای تعدیلی (برای مواردی مانند سخنان نفرتانگیز، خشونت یا اطلاعات نادرست) دارند که برخی از کاربران آن را "سانسور" مینامند. خط بین تعدیل معقول و سانسور ناخواسته میتواند مبهم باشد و اغلب به دیدگاه فرهنگی یا سیاسی بستگی دارد.

کاری که هوش مصنوعی Perplexity با DeepSeek R1 انجام داد، این ایده را مطرح میکند که مدلهای متنباز را میتوان با سیستمهای ارزشی یا محیطهای نظارتی مختلف تطبیق داد. از نظر تئوری، میتوان چندین نسخه از یک مدل ایجاد کرد: یکی که با مقررات چین مطابقت دارد (برای استفاده در چین) و دیگری که کاملاً باز است (برای استفاده در جاهای دیگر). R1 1776 اساساً مورد دوم است - یک انشعاب غیرسانسوری که برای مخاطبان جهانی در نظر گرفته شده است که پاسخهای فیلتر نشده را ترجیح میدهند. این نوع انشعاب فقط به این دلیل امکانپذیر است که وزنهای DeepSeek R1 به طور آشکار در دسترس بودند. این مزیت متنباز بودن در هوش مصنوعی را برجسته میکند: شفافیت. هر کسی میتواند مدل را بگیرد و آن را تغییر دهد، چه برای افزودن محافظت و چه، همانطور که در این مورد، برای حذف محدودیتهای اعمال شده. متنباز کردن دادههای آموزش، کد یا وزنهای مدل نیز به این معنی است که جامعه میتواند بررسی کند که چگونه مدل اصلاح شده است. (Perplexity تمام منابع دادهای را که برای غیرسانسوری استفاده کرده است، به طور کامل فاش نکرده است، اما با انتشار خود مدل، دیگران را قادر ساخته است تا رفتار آن را مشاهده کنند و حتی در صورت نیاز آن را دوباره آموزش دهند.)

این رویداد همچنین به پویاییهای ژئوپلیتیکی گستردهتر توسعه هوش مصنوعی اشاره دارد. ما شاهد نوعی گفتگو (یا رویارویی) بین مدلهای حکمرانی مختلف برای هوش مصنوعی هستیم. یک مدل توسعهیافته چینی با دیدگاههای جهانی خاص داخلی توسط یک تیم مستقر در ایالات متحده گرفته شده و تغییر داده میشود تا بازتابدهنده یک اخلاق اطلاعاتی بازتر باشد. این گواهی بر این است که فناوری هوش مصنوعی جهانی و بدون مرز چگونه است: محققان در هر کجا میتوانند بر روی کار یکدیگر بنا کنند، اما ملزم به حمل محدودیتهای اصلی نیستند. با گذشت زمان، ممکن است موارد بیشتری از این دست را شاهد باشیم - جایی که مدلها بین زمینههای فرهنگی مختلف "ترجمه" یا تنظیم میشوند. این سؤال را مطرح میکند که آیا هوش مصنوعی میتواند واقعاً جهانی باشد یا اینکه در نهایت با نسخههای خاص منطقهای مواجه خواهیم شد که به هنجارهای محلی پایبند هستند. شفافیت و باز بودن یک مسیر برای پیمایش در این مسیر ارائه میدهد: اگر همه طرفها بتوانند مدلها را بررسی کنند، حداقل بحث در مورد تعصب و سانسور به جای پنهان شدن در پشت رازهای شرکتی یا دولتی، علنی است.

در نهایت، اقدام Perplexity بر نکته کلیدی در بحث در مورد کنترل هوش مصنوعی تأکید میکند: چه کسی تصمیم میگیرد که هوش مصنوعی چه چیزی میتواند یا نمیتواند بگوید؟ در پروژههای متنباز، این قدرت غیرمتمرکز میشود. جامعه - یا توسعهدهندگان فردی - میتوانند تصمیم بگیرند که فیلترهای سختگیرانهتری را پیادهسازی کنند یا آنها را کاهش دهند. در مورد R1 1776، Perplexity تصمیم گرفت که مزایای یک مدل غیرسانسوری بیشتر از خطرات آن است و این آزادی را داشت که این تصمیم را بگیرد و نتیجه را به طور عمومی به اشتراک بگذارد. این یک مثال جسورانه از نوع آزمایشی است که توسعه هوش مصنوعی باز امکان میدهد.